컴퓨텍스2025에서 NVIDIA 키노트

오늘 컴퓨덱스 2025 키노트에서 엔비디아의 젠슨 황 CEO가 발표한 내용을 한마디로 말하자면,

“My entire keynote is your work!”

이라고 정의할 수 있다. 이 말은 이번 키노트중에 젠슨 황이 대중들에게 말한 것인데, 그 만큼 젠슨 황의 고향이자 대만의 수많은 회사들의 피와 땀을 찬양하기 위함 아닌가 싶다. 전반적으로 저도 대만 하드웨어 업체들의 견고한 생태계를 다시 한번 느끼게 되었고, 엔비디아를 등에 업고 세계로 뻗어 나가는 모습을 이번 키노트에서 확인했다.

사실 올해만 CES 2025 와 지난달 GTC에서 컨퍼런스에서 키노트를 했기 때문에, 새롭게 많은 내용을 발표하지 않았지만, 그래도 몇 가지만 전달하자면 다음과 같다.

1. NVIDIA의 제 2 캠퍼스인 대만 NVIDIA Constellation 발표

- 컴퓨텍스가 시작하기 전 부터, 대만 미디어로 부터 풍문이 돌기 시작했는 데, 소문대로 NVIDIA의 제 2 캠퍼스인 NVIDIA Constellation 이 대만에 설립한다고 공식적으로 키노트 맨 끝에 발표했다.

- 그 이전에 발표한 내용이지만, 프로젝트 이름은 정확히 발표하지 않았다. 그러나, ‘Foxconn+NVIDIA+TSMC+NSTC(대만 국가과학기술위원회)’ 가 연합해서 대만을 “스마트 AI 아일랜드”로 발전시키기 위한 기반을 마련함

- 스마트 시티, 자율주행, 로보틱스, 반도체 등 다양한 분야에서 AI 혁신을 촉진하기 위해 대만의 연구자, 스타트업, 산업계에 NVIDIA의 최신 AI 플랫폼인 1만개 이상의 Blackwell 아키텍처를 기반으로 고성능 AI 컴퓨팅 리소스를 제공할 예정임.

- 곧, 우리나라에도 새 정부가 들어서는 데 이 비슷한 규모의 작업을 추친하는 데, 단순히 NVIDIA GPU만 구입하는 것이 아니라, 국내 기업과 함께 데이터 센터를 구축하고 글로벌 생태계를 지원하는 모습으로 갔으면 하는 바램.

2. GB200 NVL72, 1조 개 이상 파라미터를 가진 LLM을 위한 AI 슈퍼컴퓨팅

- GB200 NVL72

- 구성: 36개의 Grace CPU와 72개의 Blackwell GPU를 통합한 랙 스케일 아키텍처

- 성능: 1.4 엑사플롭스의 AI 연산 성능과 30TB의 고속 메모리 제공

- 효율성: 이전 세대인 NVIDIA H100 GPU 대비 30배 빠른 실시간 추론과 25배 높은 에너지 효율성 달성

- MiTAC G4527G6

- 구성: 최대 8개의 NVIDIA RTX PRO 6000 Blackwell Server Edition GPU 또는 H200 NVL GPU 지원

- 네트워킹: ConnectX-8 SuperNIC을 통한 최대 800Gb/s의 고속 네트워킹 지원

- 용도: 트릴리언 파라미터 AI 워크로드를 위한 확장 가능한 AI 팩토리 구축에 최적화

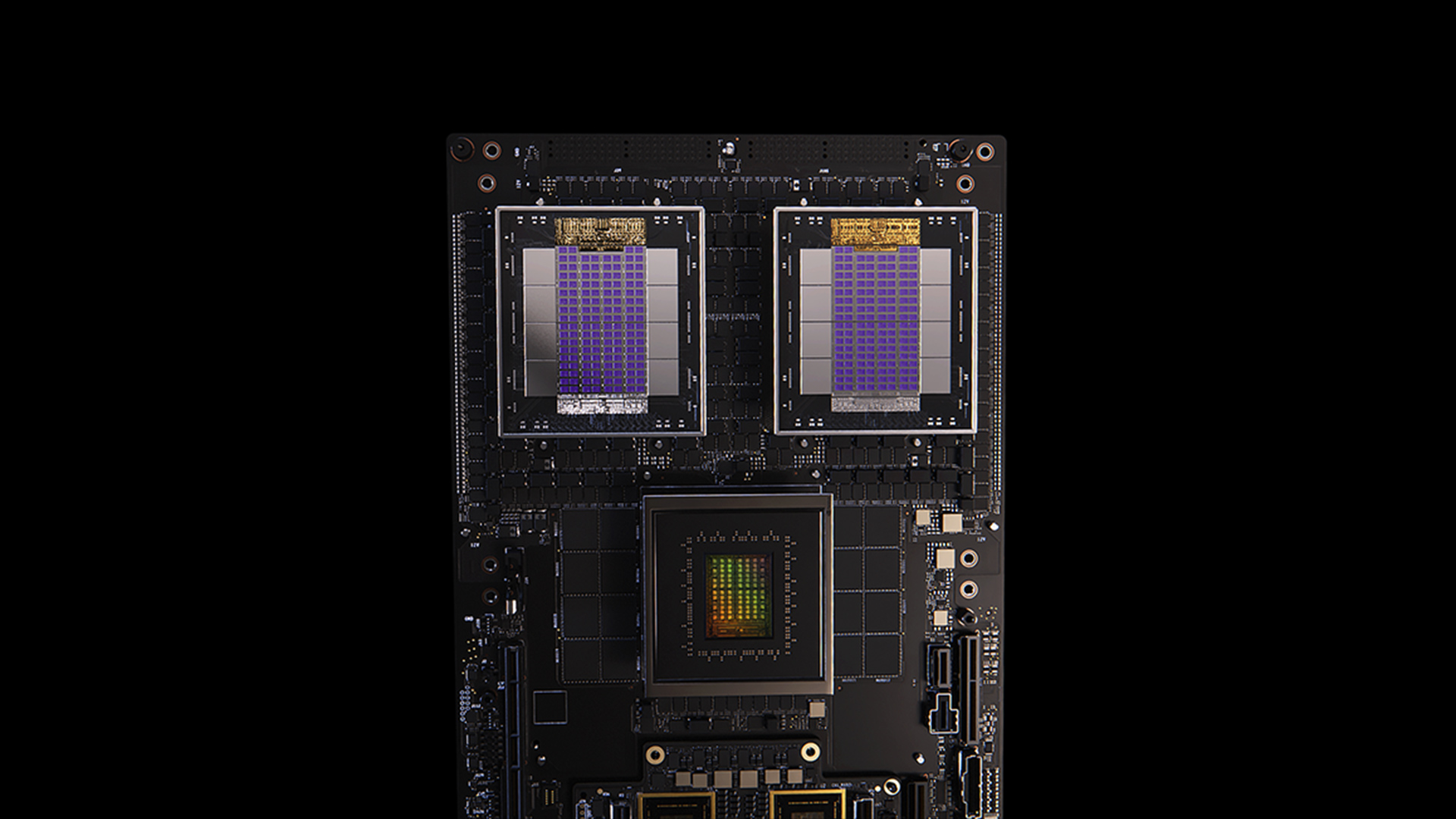

3. 세미 커스텀 AI 인프라를 구축하는 NVIDIA Fusion

- NVLink Fusion 탄생: AI가 모든 컴퓨팅 플랫폼에 통합됨에 따라, 다양한 하드웨어와 소프트웨어가 유기적으로 결합된 새로운 형태의 AI 인프라가 필요해져 데이터 센터 아키텍처의 근본적인 재구성.

- 이기종 칩 통합: Fujitsu와 Qualcomm의 CPU를 NVIDIA의 GPU와 결합하여 고성능 AI 시스템을 구성할 수 있는 데, NVIDIA의 GPU와 파트너사의 CPU 및 AI 가속기를 고속으로 연결하여 통합된 시스템을 구축가능한 것이 그 특징.

- 확장 가능한 AI 팩토리: 최대 800Gb/s의 대역폭을 제공하는 NVIDIA의 네트워킹 플랫폼(NVIDIA ConnectX-8 SuperNICs, Spectrum-X Ethernet, Quantum-X800 InfiniBand 등)과 결합되어, 수백만 개의 GPU를 효율적으로 연결하는 대규모 AI 팩토리 구축을 지원함.

-

Mission Control 소프트웨어: AI 팩토리의 운영을 자동화하고 최적화하는 NVIDIA의 Mission Control 소프트웨어를 통해, 인프라 구성, 검증, 워크로드 오케스트레이션 등을 효율적으로 관리함.

- 하드웨어 파트너 생태계 구축: 기존 NVLink 기술을 기반으로 한 새로운 인터커넥트 솔루션으로, 여러 칩 간의 빠르고 효율적인 데이터 교환을 가능하게 하고, NVIDIA 독점으로만 개발하지 않고 다양한 하드웨어 파트너들과의 협력을 통해 유연하고 확장 가능한 AI 시스템을 구축했다는 것이 큰 의미

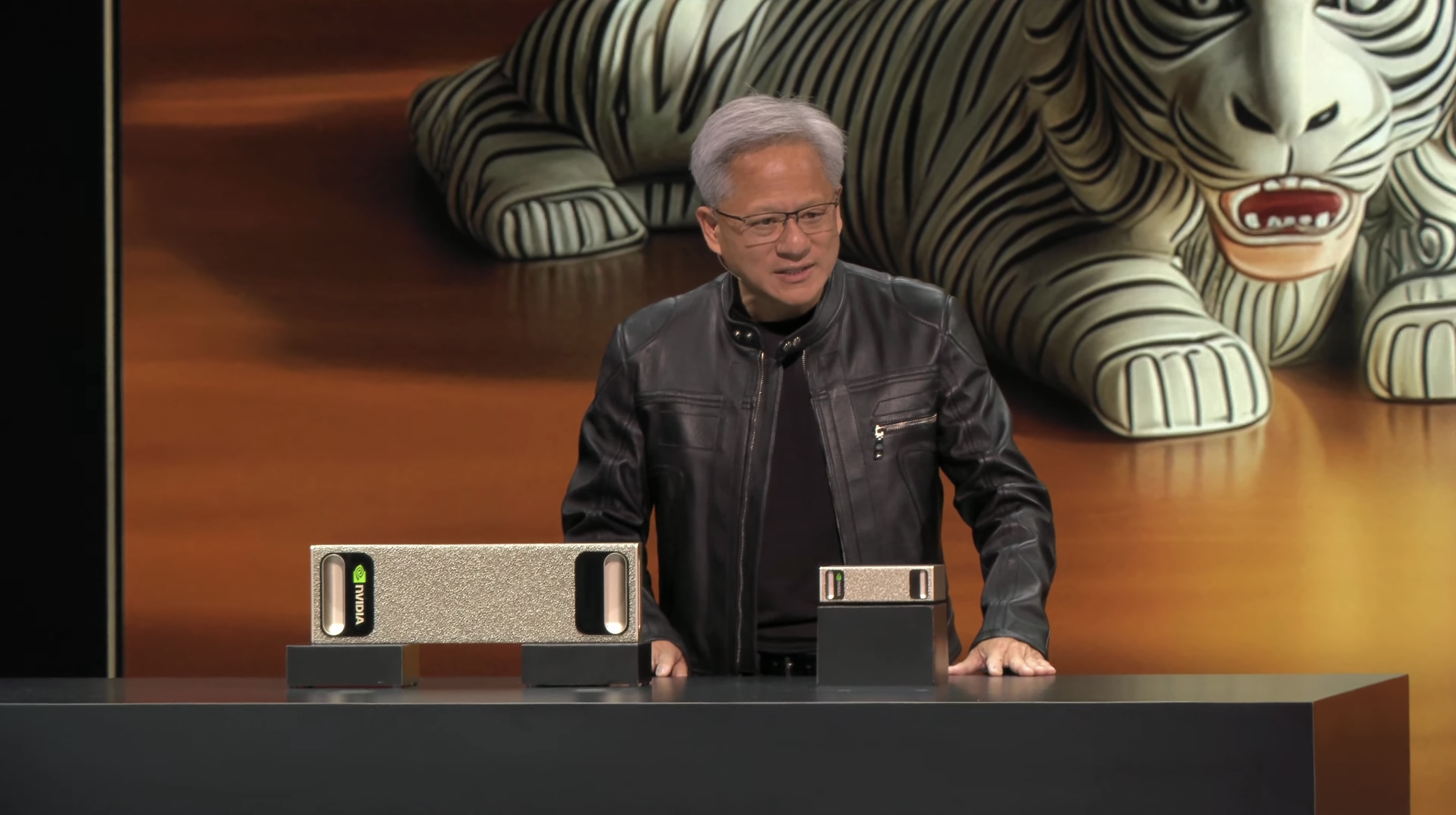

4. 개인용 AI 슈퍼컴퓨터인 DGX Spark 와 DGX Station

- NVIDIA는 Acer, GIGABYTE, MSI 등과의 협력을 통해 DGX Spark와 DGX Station의 글로벌 공급을 확대함.

- 휴대 가능한 AI 수퍼컴퓨터, DGX Spark

- GB10 Grace Blackwell 슈퍼칩 프로세서 탑재

- 128GB 통합 메모리와 최대 1페타플롭스의 AI 연산 성능 제공

- 최대 1,000 TOPS (FP4 기준), 128GB의 통합 메모리 탑재

- PyTorch, Jupyter, Ollama 등 친숙한 개발 도구 지원

- DGX Cloud 또는 기타 클라우드 인프라로의 원활한 모델 배포 가능

- 가격: 약 $3,999로 예상되며, 2025년 7월 출시 예정

- 데스크탑형 고성능 AI 워크스테이션, DGX Station:

- NVIDIA GB300 Grace Blackwell Ultra Superchip 수퍼칩 프로세서 탑재

- 784GB 통합 메모리와 최대 20페타플롭스의 AI 성능 제공

- 와 최대 20 PFLOPS (FP4 기준), 784GB의 통합 시스템 메모리와

- NVIDIA ConnectX-8 SuperNIC을 통한 최대 800Gb/s 의 고속 네트워킹 지원

- NVIDIA Multi-Instance GPU(MIG) 기술로 최대 7개의 독립적인 인스턴스 생성 가능

- ASUS, Dell, HP 등에서 2025년 하반기 출시 예정

- 1 Trillion Parameter llm 을 동작시킬 수 있다고 합니다.

- 소프트웨어 및 개발 환경

- NVIDIA DGX 운영체제와 최신 NVIDIA AI 소프트웨어 스택 사전 설치

- NVIDIA NIM™ 마이크로서비스 및 NVIDIA Blueprints 포함

- DGX Cloud와의 원활한 통합으로 클라우드 및 데이터 센터로의 확장 용이

5. RTX Pro 6000 Blackwell Server

- RTX PRO 6000 Blackwell 기반 서버

- AI, 시뮬레이션, 과학 컴퓨팅, 렌더링 등 다양한 엔터프라이즈 워크로드를 가속화하도록 설계되었음

- NVIDIA의 최신 Blackwell 아키텍처를 기반으로 한 RTX PRO 6000 GPU를 탑재하여, 엔터프라이즈 워크로드를 위한 고성능과 에너지 효율성을 제공

- 최대 8개의 GPU를 지원하며, PCIe 6세대 스위치가 내장된 NVIDIA ConnectX-8 SuperNIC와 NVIDIA BlueField-3 DPU를 포함

- 24,064개 CUDA 코어와 5세대 752개 텐서 코어, 4세대 188개 RT 코어, GPU 메모리는 96 rlrk GDDR7 (ECC 지원), 512비트로 메모리 대역폭은 1,597 GB/s , 최대 전력 소비는 600W , PCIe 5.0 16개, 폼 팩터는 듀얼 슬롯과 수동 냉각 설계를 지원함

- Enterprise AI 팩토리 검증 설계

- NVIDIA는 파트너들과 함께 RTX PRO 서버, NVIDIA Spectrum-X 이더넷 네트워킹, NVIDIA BlueField DPU, NVIDIA-Certified Storage 시스템, NVIDIA AI Enterprise 소프트웨어를 갖춘 새로운 온프레미스 인프라를 구축함

- 이를 통해 제품 설계와 엔지니어링 시뮬레이션 애플리케이션을 가속화하고, AI 지원 비즈니스 시스템과 디지털 AI 에이전트 팀을 지원함.

- 주요 파트너 및 적용 사례

- 케이던스(Cadence), 폭스콘(Foxconn), 릴리(Lilly) 등은 RTX PRO Blackwell 서버와 함께 NVIDIA Enterprise AI 팩토리 검증 설계를 사용하여 AI 팩토리를 구축

- 폭스콘은 스마트 전기 자동차, 공장 디지털 트윈, 헬스케어, 로보틱스 애플리케이션뿐만 아니라 글로벌 반도체와 전자 제품 제조를 발전시키기 위해 NVIDIA 가속 IT 인프라를 통해 AI 팩토리를 구축함

- 글로벌 생태계 및 지원

- 시스코(Cisco), 델 테크놀로지스(Dell Technologies), 휴렛팩커드 엔터프라이즈(HPE), 레노버(Lenovo) 등은 NVIDIA Enterprise AI 팩토리 검증 설계를 사용하여 풀스택 솔루션을 제공

- 어드밴텍(Advantech), 에이수스(ASUS), 기가바이트(GIGABYTE), MSI 등도 NVIDIA RTX PRO Blackwell 서버를 제공할 예정

6. NVIDIA AI Data Platform

- NVIDIA AI Data Platform은 엔비디아가 기업용 AI 인프라를 혁신하기 위해 개발한 차세대 데이터 처리 플랫폼

- NVIDIA AI-Q(에이전틱 AI)를 지원하는 데 중점을 두고 있으며, 기업의 스토리지 시스템과 고성능 컴퓨팅을 통합하여 실시간 비즈니스 인사이트를 제공하는 것을 목표로 함.

- Dell, HPE, IBM, NetApp, DDN, Hitachi Vantara, Pure Storage, Nutanix, VAST Data 등 주요 스토리지 공급업체와 협력함.

7. 키노트를 보면서 느낀점

- 이번 컴퓨텍스 2025 젠슨황 키노트에서 데스크탑 워크스테이션 부터 보드, NVLink Switch, 마더 보드, 수퍼 컴퓨팅 데이터 센터에 설치하는 서버 시스템까지 실물을 직접 데모로 보여주는 ‘시각화 데모’가 더욱 더 발전하는 모습이라서 저도 그러한 키노트 발표회를 많이 했던 스피커로써 흥미롭게 보았다.

댓글남기기